«`html

Meta представляет новую модель — SAM 2: первую унифицированную модель для сегментации объектов на изображениях и видео

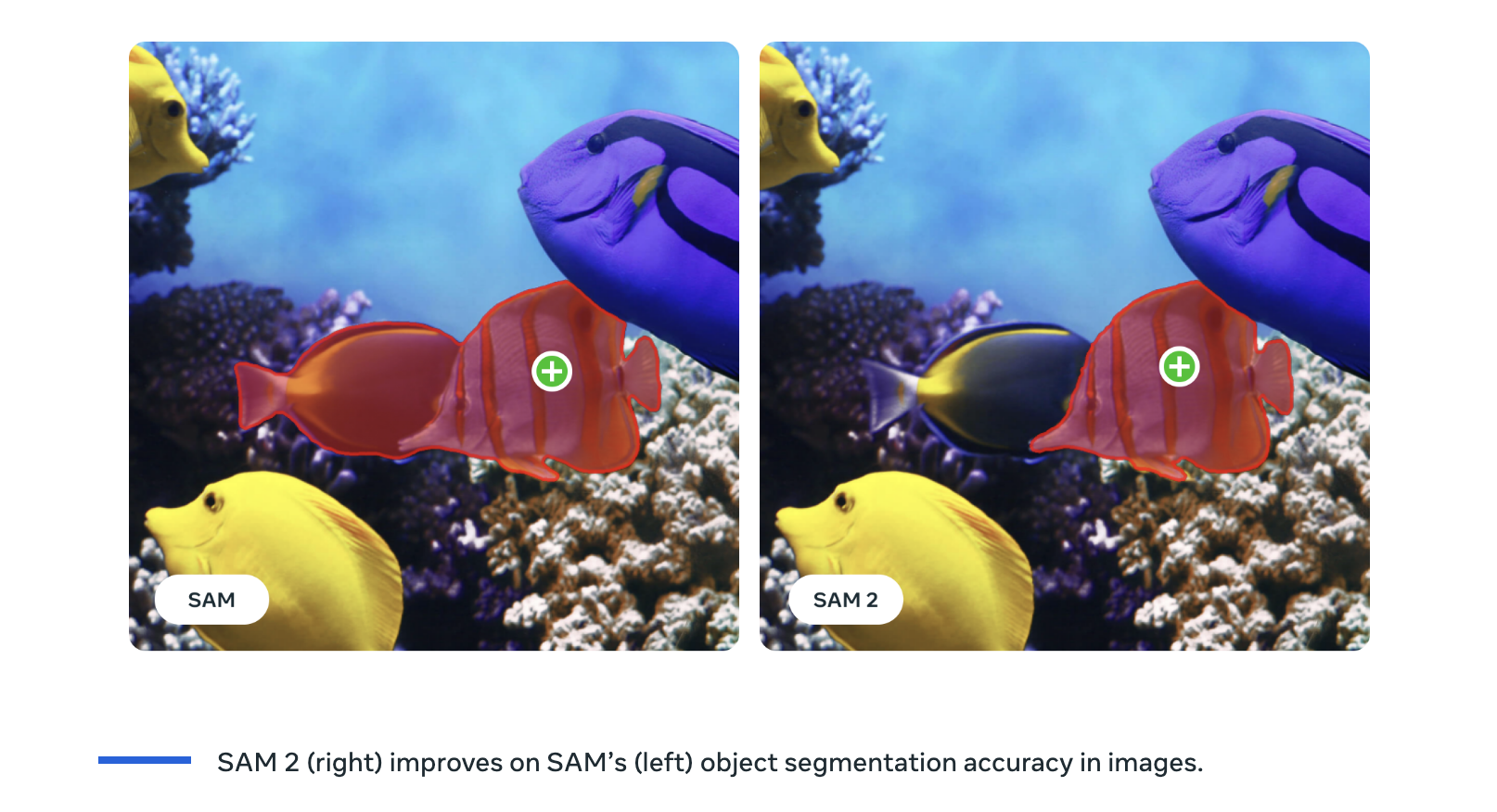

Meta представила SAM 2, следующее поколение своей модели Segment Anything Model. SAM 2 — это новаторская унифицированная модель, предназначенная для моментальной сегментации объектов на изображениях и видео. Она расширяет возможности оригинальной модели SAM, добавляя поддержку видеоданных и обеспечивая моментальную сегментацию и отслеживание объектов на протяжении нескольких кадров.

Преимущества и применение SAM 2

SAM 2 обладает высокой эффективностью: требуется в три раза меньше времени для взаимодействия, при этом достигается превосходная точность сегментации изображений и видео. Это критически важно для практических применений, где время и точность играют важную роль.

Потенциальные области применения SAM 2 весьма разнообразны: в креативной индустрии модель может генерировать новые видеоэффекты, улучшая возможности генеративных видеомоделей и открывая новые пути для создания контента. В сфере аннотации данных SAM 2 может ускорить маркировку визуальных данных, улучшая обучение будущих систем компьютерного зрения. Это особенно полезно для отраслей, основанных на обширных наборах данных для обучения, таких как автономные транспортные средства и робототехника.

SAM 2 обещает применение в научных и медицинских областях, например, для сегментации движущихся клеток в микроскопических видео, что помогает в исследованиях и диагностике. Возможность отслеживания объектов на видео с дронов может помочь в мониторинге дикой природы и проведении экологических исследований.

Открытость и инновации

В рамках принципов открытой науки Meta предоставляет код и веса модели SAM 2 под лицензией Apache 2.0, поощряя сотрудничество и инновации в сообществе специалистов по искусственному интеллекту. Компания также выпустила набор данных SA-V, включающий около 51 000 реальных видео и более 600 000 пространственно-временных масок под лицензией CC BY 4.0. Этот набор данных значительно превосходит предыдущие, предоставляя обширные ресурсы для обучения и тестирования моделей сегментации.

Технические инновации в SAM 2

Разработка SAM 2 включает значительные технические инновации, включая архитектуру модели, позволяющую обрабатывать видеоданные. Это включает механизм памяти, который позволяет модели точно сегментировать объекты на видеокадрах. Команда разработчиков также создала задачу моментальной визуальной сегментации, позволяющую модели принимать вводные данные на любом видеокадре и предсказывать маску сегментации, которая затем применяется ко всем кадрам для создания пространственно-временной маски.

Заключение

SAM 2 предлагает беспрецедентные возможности моментальной сегментации объектов на изображениях и видео. Ее универсальность, эффективность и открытый исходный код делают ее ценным инструментом для многих областей, от креативной индустрии до научных исследований. Публикация SAM 2 от Meta способствует инновациям и сотрудничеству, предлагая путь к будущим достижениям в технологии компьютерного зрения.

«До сегодняшнего дня аннотация масок на видео была неудобной; совмещение первой модели SAM с другими моделями сегментации объектов на видео. С появлением SAM 2 аннотация масок достигнет совершенно нового уровня. Я считаю, что заявленное увеличение скорости в 8 раз — это нижняя граница того, что можно достичь с правильным пользовательским интерфейсом, и с более чем 1 миллионом выводов с использованием SAM на платформе Encord, мы видели огромную ценность, которую могут предоставить модели такого типа командам машинного обучения.» — Dr Frederik Hvilshøj — руководитель отдела машинного обучения в Encord

Проверьте статью, загрузите модель, набор данных и попробуйте демонстрационную версию здесь.

Авторство исследования принадлежит команде проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашему каналу в Telegram и группе в LinkedIn. Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему сообществу более чем 47 000 пользователей нашего подразделения по машинному обучению (ML SubReddit).

Узнайте о предстоящих вебинарах по искусственному интеллекту здесь.

Эта публикация была впервые опубликована в MarkTechPost.

«`